2010年09月16日

A/Bテストの精度を高め、すぐに試せるデータのチェック方法

ユーザビリティコンサルタント

酒巻 厚志

A/Bテストを行う際、測定して得られたデータが正しいことが、その後の施策を検討する上での前提となります。

しかし、本当にそのデータは正しいのでしょうか?収集するデータの量が不十分な場合、必ずしも正しいとはいえないこともあります。

データが誤っていると考えられる例

例えば、A/Bテストのデータが誤っていると考えられる例として、まったく同じページでA/Bテストを行った結果、コンバージョンレートに2割程度の差が出た、という報告があります。

ABtests.com: 22.5% improvement on sign-up page (会員登録ページのコンバージョン率を22.5%改善)

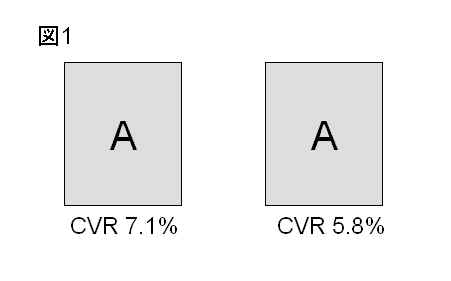

上記の記事では、会員登録をコンバージョン指標として実験を行い、まったく同じページなのにもかかわらず、一方でのコンバージョン率(CVR)が 7.1%、もう一方では5.8%という結果が出た、という報告がなされています。(図1)

この結果に対しては、「信頼に足るほど十分なデータが収集できていないのではないか?」という議論が交わされていますが、おそらくその通りでしょう。この段階ではまだ正しい値にデータが落ち着いておらず、もう少しデータを取って判断すべきだと考えられます。

A/Bテストでデータの信憑性をチェックする方法

上の例では同じページを比較しているのでデータが正しいのかどうかの判断ができますが、異なるページで比較するA/Bテストでデータの正確性を見極めるのは困難です。/p>

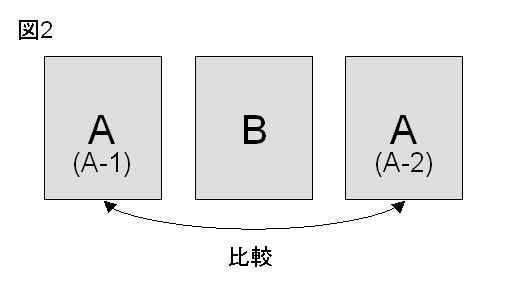

そこで、正しく判断するための方法としてA/B/Aテストを行う方法があります。

A/B/Aテストとは、効果を比較したいAとBの2パターンを試す際に、全体のトラフィックを3分割し、A(A-1とします)、B、そして比較用の A(A-2とします)の3パターンを走らせることでデータの信憑性をチェックする方法です。データがたまってきたら、A-1とA-2のデータを比べ、2つに差がなければその期間のデータは信用して良いと考えます。(図2)

逆に、A-1とA-2の2つのデータに明らかに統計的に有意な差が出ていれば、データの測定方法が正しいのか確認し、測定方法が正しければA-1とA-2 の差異が出なくなる程度にデータが落ち着くまでウォッチする、というような判断が必要です。

- 広告効果測定ツールなら